Em resposta ao anúncio do Google sobre o Gemini 2.0, considerado muito superior ao lançamento fracassado do Bard, a OpenAI, proprietária do ChatGPT, apresentou seu mais novo modelo, o o3. A nomenclatura tem gerado confusão: o próprio CEO da empresa, Sam Altman, reconheceu ser estranho que o o3 suceda o o1, que substituiu o GPT-4o. Alguns sugerem que o nome “o2” foi evitado devido a possíveis conflitos com marcas registradas. No entanto, há outra teoria: o “3” no nome o3 refere-se à ordem de grandeza dos custos envolvidos na execução de uma tarefa pelo modelo.

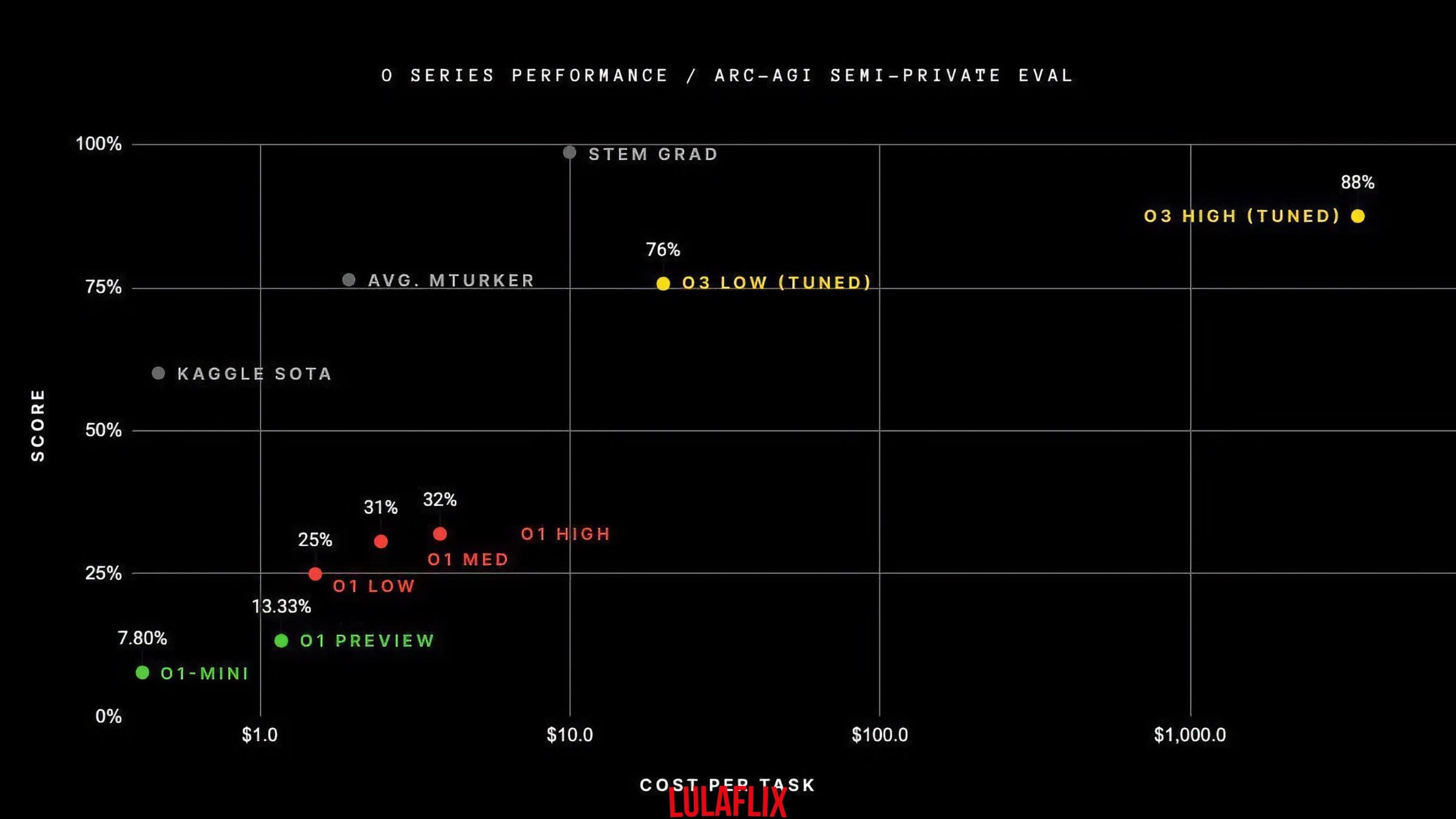

A imagem que ilustra esta coluna exibe um gráfico comparativo do desempenho de diferentes modelos (incluindo seres humanos) na resolução de problemas do conjunto ARC-AGI, projetado para ser particularmente desafiador para máquinas. Esse conjunto serve como parâmetro para avaliar o quão próximos estamos de alcançar uma “inteligência artificial de propósito geral”. No eixo horizontal, observam-se os custos por problema resolvido. Para o o3, cujo desempenho é inegavelmente excelente, o custo ultrapassa US$1 mil por problema, enquanto para o o1, no pior cenário, aproxima-se de US$10.

Como esse modelo de negócios pode ser sustentável? Neste ano, surgiram notícias de que a OpenAI enfrentará um prejuízo astronômico de US$5 bilhões, apesar de sua receita de US$3,7 bilhões. Já discutimos nesta coluna o mecanismo predatório dos especuladores no setor de tecnologia. O Uber, por exemplo, tornou-se lucrativo pela primeira vez no último trimestre de 2023, algo surpreendente para uma empresa de tal magnitude. Essa é a lógica da corrida pelo monopólio no Vale do Silício. Ainda assim, as empresas de inteligência artificial operam numa escala inédita de prejuízos, e a possibilidade de uma bolha nesse setor é preocupante, dado que apenas uma empresa tende a sair vencedora.

A OpenAI não é uma simples startup competindo diretamente com o Google. É financiada majoritariamente pela Microsoft, além de outros investidores e empresas de peso. Seus objetivos iniciais de criar uma inteligência artificial aberta (daí o nome “Open”), acessível a todos, foram abandonados em prol dos impopulares modelos por assinatura. Curiosamente, o Facebook é a única grande empresa que mantém parte de seu desenvolvimento em inteligência artificial aberto ao público.

É praticamente impossível que uma empresa iniciante, sem um grande aporte financeiro, entre nesse mercado. Basta observar o investimento bilionário de Elon Musk na construção de um centro de processamento de dados para sua iniciativa, o Grok. Há duas razões principais para os custos exorbitantes: o preço elevado dos chips de alta performance, dominado pela empresa norte-americana Nvidia, e o altíssimo consumo energético desses centros de processamento, reflexo da imensa quantidade de dados necessária para treinar modelos como o o1 ou, agora, o o3 da OpenAI.

O consumo energético é particularmente problemático, pois se trata de um custo operacional constante. Alguém pode perguntar: se é tão caro, como é possível usar o ChatGPT de graça? Essa é a grande questão. Se você o utiliza gratuitamente, leitor, é porque você é o produto, oferecendo feedback para as equipes de pesquisa da OpenAI, Google, Anthropic ou outra empresa do setor. Além disso, cada pergunta feita pelos usuários representa um prejuízo financeiro para essas empresas, que buscam coletar mais dados para aprimorar seus modelos enquanto competem por uma fatia maior desse mercado altamente disputado.

Não é à toa que empresas como a Microsoft têm cientistas nucleares em sua folha de pagamento. Essas companhias consideram a possibilidade de construir usinas nucleares próprias para sustentar a demanda energética de seus modelos de aprendizado de máquina. Parece que a privatização do setor energético está prejudicando até mesmo os maiores monopólios do mundo!

De qualquer maneira, no ritmo atual, sem considerações sobre desempenho e eficiência energética, não estamos diante de um ciclo virtuoso no desenvolvimento da inteligência artificial, mas sim de uma corrida rumo ao fundo do poço.